-

467. Se méfier de l’assistanat

« Le 30 octobre, le président américain, Joe Biden, a dévoilé les grandes lignes d’un décret “qui exige une évaluation des problèmes de sécurité, des directives concernant l’égalité et les droits civiques et une étude des répercussions de l’IA sur le marché du travail”. Il entend ainsi s’inscrire dans le vaste mouvement autour de la régulation étatique de l’intelligence artificielle. Sur la nécessité de réguler l’IA, tout le monde est d’accord /…/ Mais aux États-Unis, en Europe et en Chine, les approches divergent. Et personne ne sait comment s’y prendre pour harmoniser les points de vue ».

« Le 30 octobre, le président américain, Joe Biden, a dévoilé les grandes lignes d’un décret “qui exige une évaluation des problèmes de sécurité, des directives concernant l’égalité et les droits civiques et une étude des répercussions de l’IA sur le marché du travail”. Il entend ainsi s’inscrire dans le vaste mouvement autour de la régulation étatique de l’intelligence artificielle. Sur la nécessité de réguler l’IA, tout le monde est d’accord /…/ Mais aux États-Unis, en Europe et en Chine, les approches divergent. Et personne ne sait comment s’y prendre pour harmoniser les points de vue ».Ce que l’on constate, c’est que tout le monde s’affole. L’homo sapiens s’aperçoit qu’il vient de créer un outil dont les possibilités risquent de se retourner contre lui. Il a ouvert une boite de Pandore, et il est démuni devant ce qui peut en sortir. Le paradoxe est que ce qui peut en sortir n'est que ce qu’il a mis dedans, il a mis les ingrédients, et la machine en fait un plat. Mais l’homo sapiens a ses faiblesses et s’il met dans la machine de mauvais ingrédients quel goût aura le plat et pourrait-il contenir un poison ?

Une étude menée par Lucia Vicente et Helena Matute, du département de psychologie de l'Université de Deusto (Bilbao, Espagne) a été publiée dans la revue Scientific Reports et montre que des biais introduits volontairement dans les algorithmes (mais ils peuvent être involontaires lors de leur création) vont induire des erreurs que les médecins continueront à commettre lorsqu’ils ne se serviront plus de l’assistance de l’IA.

Les auteurs de l’étude ont demandé à des étudiants en psychologie de faire un diagnostic médical : ils devaient identifier, à partir d'échantillons tissulaires et de leurs colorations, les patients potentiellement atteints d'une maladie fictive spécifique. Le groupe assisté par l’IA a commis les erreurs qui avaient été introduites dans la machine, contrairement au groupe qui ne bénéficiait pas de cette assistance. Après désactivation de l’IA, lors de la poursuite des tests, le groupe qui avait été assisté par l’IA a continué à se tromper en ayant en quelque sorte hérité du « raisonnement » défectueux de la machine. Cette opération a été répétée trois fois sur des groupes différents avec les mêmes résultats.

« Pour les chercheuses, ces résultats prouvent que les humains héritent des biais de l'IA et que des informations biaisées provenant de l'IA peuvent avoir un impact négatif sur les décisions humaines dans des secteurs critiques tels que la médecine. De plus, cette influence pourrait persister à long terme. ».

Les professeurs ne vont peut-être pas disparaître.

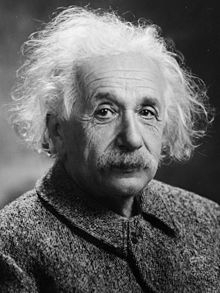

Illustration : John William Waterhouse "Pandore"

-

Commentaires

Moi je trouve qu'on prête à l'IA une dangerosité qu'il n'a pas. L'erreur qu'ont commis les étudiants influencés par l'IA aurait été la même si c'était un professeur en qui ils avaient confiance qui s'était trompé ou leur avait fait une farce.

La crainte des gouvernants et des décideurs vient peut-être seulement du fait que, en étant capable d'intégrer et de synthétiser des millions d'informations disparates, l'IA soit capable de trouver des corrélations qui contrediraient leurs analyse. Mais ca ne fera pas de l'IA un décideur.

Un exemple me vient à l'esprit : on raconte que ce sont les statistiques établies par les ordinateurs des compagnies d'assurance qui montré les premiers le rapport existant entre l'hypertension artérielle et une mortalité précoce. Mais pour avoir trouvé cela, ces ordinateurs ne sont pas devenus médecins pour autant.

-

Mardi 31 Octobre 2023 à 23:17

Comme vous le savez, il ne s'agit pas de simples statistiques mais d'une synthèse de connaissances qui peut aisément prendre la place de travailleurs intellectuels. L’entreprise Onclusive, spécialiste de la communication - synthèse des informations pour les entreprises - a supprimé 237 postes qualifiés sur 383. Ce n'est pas un saut quantitatif, mais qualitatif.

-

3Souris doncMercredi 1er Novembre 2023 à 10:50-

Souris doncMercredi 1er Novembre 2023 à 11:47

Impossible de mettre ce chat (GPT) à la bonne dimension.

A la place, une brève de comptoir :

- C'est quoi, l'intelligence artificielle ?

- C'est la vôtre, patron.

-

Mercredi 1er Novembre 2023 à 11:55

-

Al WestMercredi 1er Novembre 2023 à 18:01

Dr WO,

J'ai trouvé ça pour vous.

-

Mercredi 1er Novembre 2023 à 18:24

-

Suivre le flux RSS des commentaires

Suivre le flux RSS des commentaires

Ajouter un commentaire

Ajouter un commentaire

Le blog sans ordonnance de Paul Obraska

Je préfère l'intelligence naturelle. Je vais même plus loin: j'exige qu'elle soit totalement bio. Blague à part, l'utilisation de l'IA risque de nous entraîner vers une catastrophe planétaire. Et si elle déclarait la guerre mondiale?

Il y a comme un affolement dans la plupart des pays. Quand on passe en revue la réaction des gouvernements que j'ai pu voir, ils disent tous qu'ils vont prendre des mesures, mais manifestement ils ne savent pas lesquelles. L'Italie avait interdit d'utiliser CHAT/GPT, mais cette interdiction vient d'être levée.